Las técnicas de regresión se cuentan entre los métodos más

utilizados en la Estadística Aplicada. Dada una variable de respuesta

![]() y un conjunto de covariables

y un conjunto de covariables

![]() , es de interés

estimar una supuesta relación funcional entre

, es de interés

estimar una supuesta relación funcional entre ![]() y

y ![]() , así

como predecir el valor de observaciones futuras para distintos valores de

las covariables.

, así

como predecir el valor de observaciones futuras para distintos valores de

las covariables.

Una manera de modelar dicha relación consiste en representar el valor

esperado de ![]() como

como

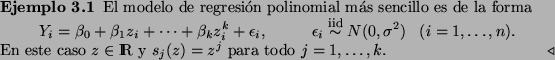

Este planteamiento da lugar a los llamados modelos lineales

generalizados. En esta sección nos concentraremos en el modelo de

regresión usual, donde la variable ![]() tiene una distribución Normal

y

tiene una distribución Normal

y ![]() es la función identidad.

es la función identidad.

El modelo Normal

Supongamos que se tienen ![]() observaciones independientes

observaciones independientes

![]() del modelo

del modelo

Sean

![]() y

y

Resulta conveniente escribir el modelo en forma matricial. Sea ![]() .

Entonces

.

Entonces

En el resto de esta sección supondremos que la matriz ![]() es de

rango completo,

es de

rango completo, ![]() .

.

La función de verosimilitud para el modelo (4) es de la forma

Para facilitar la notación y el desarrollo subsecuente, es conveniente

trabajar en términos de la precisión

![]() en lugar de la

varianza

en lugar de la

varianza ![]() . La verosimilitud toma entonces la forma

. La verosimilitud toma entonces la forma